Importância e os desafios na manutenção da qualidade de dados na Cloud

No contexto de Engenharia de Dados, a qualidade de dados é uma questão de extrema importância, pois a precisão, completude e confiabilidade dos dados são essenciais para uma tomada de decisões eficiente e informada.

Em um ambiente onde as empresas dependem cada vez mais de grandes volumes de dados para orientar suas estratégias e operações, assegurar a qualidade dos dados tornou-se um desafio crítico.

O principal problema enfrentado neste cenário é a presença de dados de baixa qualidade, que podem incluir dados incompletos, duplicados, inconsistentes ou incorretos.

Tais falhas comprometem a precisão das análises e podem levar a decisões equivocadas, afetando negativamente os resultados de negócios.

O problema na qualidade dos dados

A diversidade de fontes de dados, cada uma com seus próprios formatos e padrões, contribui para esse problema, tornando difícil integrar e harmonizar os dados de maneira eficaz.

Além disso, a falta de processos robustos de governança de dados agrava a situação, permitindo que erros e inconsistências se proliferem sem controle adequado.

Para resolver esse problema, é fundamental implementar uma estratégia abrangente de qualidade de dados.

Essa estratégia deve englobar processos de validação e limpeza de dados, assegurando que apenas dados precisos e relevantes sejam utilizados nas análises e tomadas de decisões.

Ferramentas de ETL (Extract, Transform, Load) desempenham um papel crucial nesse contexto, permitindo extrair dados de várias fontes, transformá-los para corrigir erros e inconsistências, e carregá-los em repositórios centralizados de maneira organizada e acessível.

Além disso, a adoção de práticas rigorosas de governança de dados, incluindo a definição de padrões e políticas claras para a gestão de dados, é essencial para manter a integridade e a consistência dos dados ao longo do tempo.

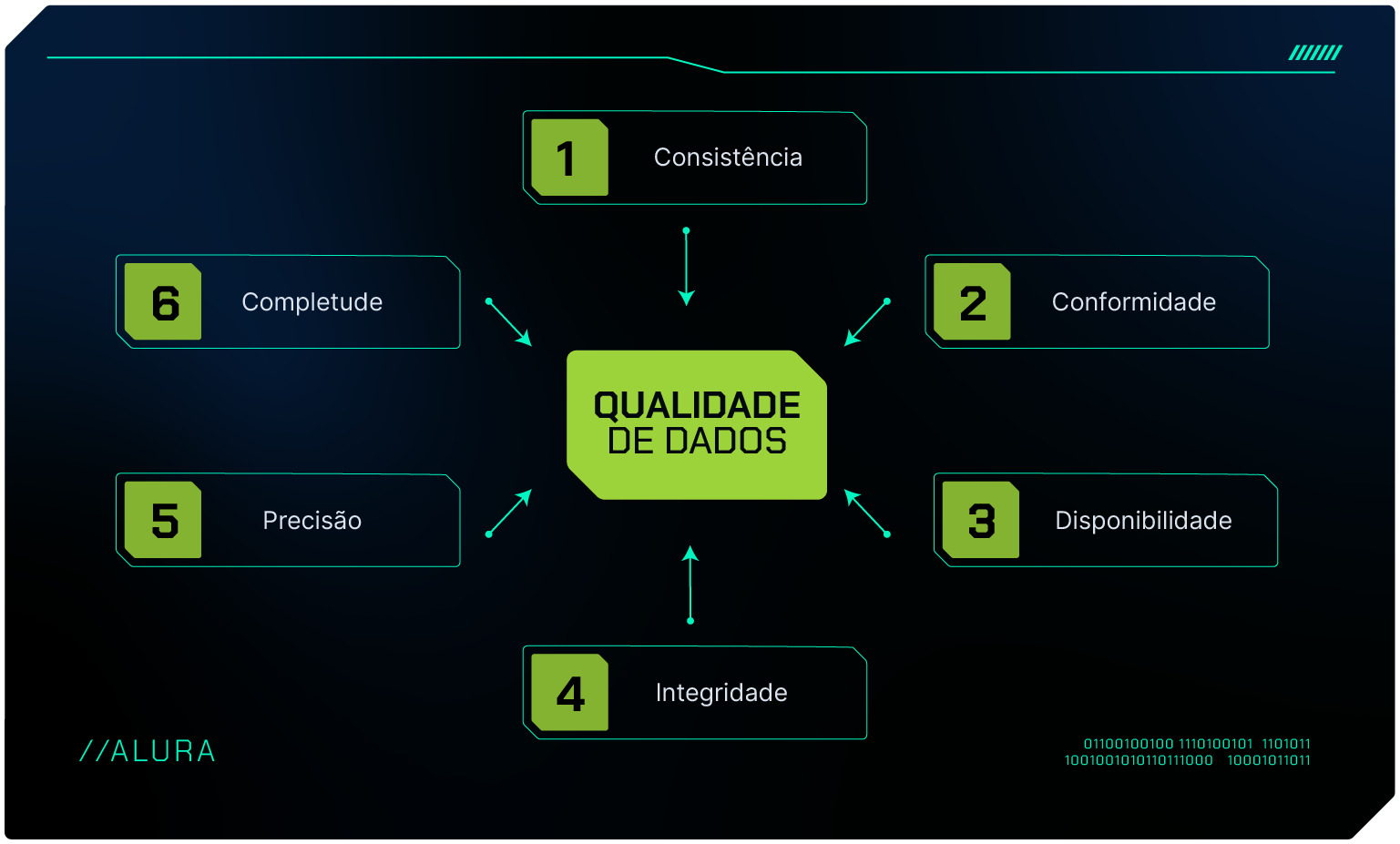

A teoria por trás da qualidade de dados baseia-se em cinco dimensões principais da DAMA (Data Management Association) que incluem: completude, precisão, consistência, atualidade e integridade.

Estes princípios ajudam a construir uma base sólida para a gestão de dados de alta qualidade.

DAMA na Qualidade de Dados

O DAMA (Data Management Association) é uma organização internacional que promove as melhores práticas e padrões em gestão de dados.

No contexto da qualidade de dados, o DAMA fornece um framework abrangente que aborda diversas áreas críticas, incluindo governança de dados, integração, armazenamento, segurança e, principalmente, a qualidade dos dados.

O modelo DAMA enfatiza a importância de políticas e procedimentos claros para garantir a precisão, consistência, completude e atualidade dos dados.

Ao seguir as diretrizes do DAMA, as organizações podem estabelecer uma base sólida para a gestão de dados eficaz, melhorando a confiabilidade das informações e apoiando a tomada de decisões estratégicas.

Este framework é amplamente reconhecido e utilizado para desenvolver programas de qualidade de dados robustos, assegurando que os dados sejam gerenciados de maneira holística e integrada.

O pilar de qualidade do DAMA é uma parte central do seu framework de gestão de dados, abordando aspectos cruciais para assegurar que os dados sejam confiáveis e utilizáveis.

A seguir vamos aprender sobre as dimensões da qualidade de dados segundo a DAMA.

Principais dimensões da qualidade de dados

As principais dimensões da qualidade de dados são fundamentais para entender e garantir a integridade, precisão e utilidade dos dados em qualquer organização.

Estas dimensões são frequentemente usadas para avaliar e melhorar a qualidade dos dados, assegurando que eles sejam adequados para suportar a tomada de decisões e outras operações críticas.

As cinco dimensões principais incluem completude, precisão, consistência, atualidade e integridade.

Completude

Completude refere-se à presença de todos os dados necessários. Um conjunto de dados é considerado completo quando todas as informações obrigatórias estão presentes.

A falta de completude pode ocorrer quando há dados ausentes, o que pode ser devido a falhas na coleta de dados, problemas de integração entre sistemas ou entradas de dados incompletas.

Por exemplo, em um banco de dados de clientes, a completude seria garantida se todos os registros contivessem informações essenciais como nome, endereço, e-mail e número de telefone.

A falta dessas informações pode comprometer a capacidade da empresa de contatar seus clientes ou de realizar análises de mercado precisas.

Precisão

Precisão refere-se à exatidão dos dados, ou seja, a medida em que os dados refletem corretamente a realidade que pretendem representar. Dados precisos são essenciais para análises confiáveis e decisões informadas.

A precisão pode ser afetada por erros de entrada de dados, falhas de medição ou inconsistências na coleta de dados.

Por exemplo, se um sistema registra a temperatura ambiente e o sensor está com defeito, os dados coletados serão imprecisos, levando a conclusões erradas sobre as condições ambientais.

Consistência

Consistência se refere à uniformidade dos dados em diferentes sistemas ou dentro do mesmo sistema ao longo do tempo.

Dados consistentes não apresentam conflitos ou discrepâncias entre diferentes registros ou fontes.

Por exemplo, um cliente que aparece com diferentes endereços de e-mail em duas bases de dados distintas representa uma inconsistência.

A falta de consistência pode surgir de integrações de sistemas mal gerenciadas, entradas de dados duplicadas ou falta de sincronização entre sistemas.

Atualidade

A atualidade, ou temporalidade, refere-se à relevância temporal dos dados, ou seja, a medida em que os dados estão atualizados e refletem as condições atuais.

Dados desatualizados podem levar a decisões baseadas em informações obsoletas, o que pode ser prejudicial para a operação e estratégia da empresa.

Por exemplo, utilizar dados de vendas do ano passado para prever a demanda atual pode resultar em previsões incorretas.

Integridade

Integridade refere-se à integridade estrutural dos dados, garantindo que todos os relacionamentos e regras de negócios definidos sejam respeitados.

Isso inclui a conformidade com restrições de integridade referencial, integridade de domínio e outras regras que asseguram que os dados sejam completos e válidos em seu contexto. Por exemplo, uma tabela de transações financeiras deve garantir que todas as referências a contas de clientes correspondem a registros válidos na tabela de clientes. Violações de integridade podem ocorrer devido a erros de entrada de dados, falhas de sistema ou falta de validação adequada.

Aplicação das dimensões de qualidade de dados

Aplicar as dimensões da qualidade de dados na cloud envolve a implementação de práticas, ferramentas e políticas específicas que garantem a integridade, precisão e usabilidade dos dados em um ambiente de computação em nuvem.

A completude dos dados na cloud pode ser garantida definindo e aplicando regras de integridade para assegurar que todos os campos obrigatórios sejam preenchidos antes de carregar os dados na nuvem.

Ferramentas de monitoramento ajudam a identificar e corrigir dados incompletos, assegurando que todos os dados necessários estejam presentes.

Para garantir a precisão dos dados na cloud, é essencial utilizar ferramentas de validação de dados durante a entrada e a ingestão, automatizar verificações de precisão e implementar processos de limpeza de dados para corrigir erros e inconsistências.

Ferramentas de ETL (Extract, Transform, Load) modernas oferecem funcionalidades de transformação e limpeza que ajudam a assegurar a precisão.

Manter a consistência dos dados em diferentes sistemas e fontes é crucial. Isso pode ser alcançado através da padronização de dados, harmonizando diferentes formatos e esquemas, e estabelecendo processos de sincronização para garantir que os dados sejam consistentes em todas as fontes e sistemas.

A atualidade dos dados é garantida automatizando processos de atualização de dados para assegurar que estejam sempre atualizados e utilizando serviços de streaming de dados para monitorar e atualizar dados em tempo real.

Para assegurar a integridade dos dados, é importante utilizar chaves primárias e estrangeiras para manter a integridade referencial nos bancos de dados. Implementar validações de integridade nos processos de ETL ajuda a garantir que as relações entre dados sejam preservadas.

Exemplos de ferramentas

Para implementar essas dimensões da qualidade de dados na cloud, várias ferramentas e serviços podem ser utilizados, como AWS Glue para ETL e transformação de dados, Google Cloud Dataflow para processamento de dados em tempo real e em lote, Azure Data Factory para integração e transformação de dados, Apache Kafka para streaming de dados em tempo real, e Talend e Informática para integração, limpeza e governança de dados.

Ferramentas de gerenciamento de acesso e segurança, como AWS IAM, Azure Active Directory e Google Cloud IAM, são essenciais para a segurança dos dados.

Aplicar as dimensões da qualidade de dados na cloud exige uma abordagem multifacetada que combina processos robustos, ferramentas avançadas e políticas claras.

Implementando essas estratégias, as organizações podem garantir que seus dados na nuvem sejam precisos, completos, consistentes, íntegros, atualizados, acessíveis, relevantes, conformes, credíveis e únicos, maximizando o valor dos dados para a tomada de decisões estratégicas e operacionais.

Prós e contras da aplicação das dimensões da qualidade de dados

Assim como em qualquer processo, a aplicação das dimensões da qualidade de dados na nuvem apresenta vantagens e desafios.

Prós

As vantagens da aplicação das dimensões da qualidade de dados são:

Tomada de Decisões: Dados de alta qualidade fornecem uma base sólida para análises precisas e decisões informadas.

Eficiência Operacional: Melhoria na eficiência dos processos de negócio, reduzindo erros e retrabalhos.

Satisfação do Cliente: Permite entender melhor as necessidades e preferências dos clientes, oferecendo produtos e serviços mais alinhados.

Conformidade Regulatória: Ajuda a garantir que as organizações cumpram normas e regulamentos, evitando penalidades e danos à reputação.

Contras

As desvantagens da aplicação das dimensões da qualidade de dados são:

Custos: Implementação de processos e ferramentas pode ser dispendiosa, incluindo investimento em tecnologia e treinamento.

Complexidade: Gestão da qualidade de dados pode ser complexa, especialmente com múltiplas fontes e sistemas.

Resistência Interna: Mudanças nos processos de gestão de dados podem encontrar resistência dentro da organização.

Sobrecarga de Dados: Focar excessivamente na coleta de dados detalhados pode levar à sobrecarga de informações, resultando em análises lentas.

Conclusão

A qualidade de dados é essencial para a eficácia organizacional, oferecendo benefícios significativos como melhor tomada de decisões, maior eficiência operacional, satisfação do cliente e conformidade regulatória.

No entanto, manter essa qualidade apresenta desafios, incluindo altos custos de implementação, complexidade na gestão, resistência interna a mudanças e o risco de sobrecarga de informações.

Portanto, as organizações devem equilibrar cuidadosamente os benefícios e os desafios ao desenvolver e implementar suas estratégias de gestão de dados para maximizar o valor e a utilidade dos dados.